728x90

Sung Kim님(김성훈 교수님)의 유튜브를 보고 공부한 AI 입니다.

Sung Kim님(김성훈 교수님)의 유튜브 주소 : www.youtube.com/channel/UCML9R2ol-l0Ab9OXoNnr7Lw

Sung Kim

컴퓨터 소프트웨어와 딥러닝, 영어등 다양한 재미있는 이야기들을 나누는 곳입니다.

www.youtube.com

cost를 구하는 공식을 간단히 해보겠습니다.

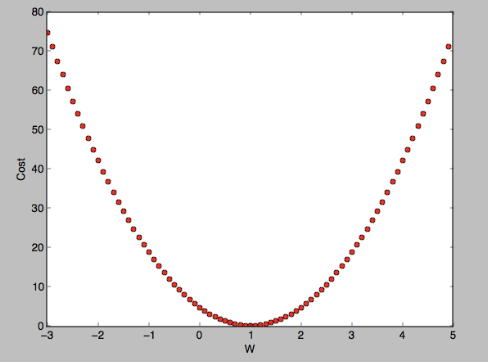

이 공식을 토대로 W를 임의의 수를 지정하고 data set을 가지고 대입하여 그래프를 그려보겠습니다.

| X | Y |

| 1 | 1 |

| 2 | 2 |

| 3 | 3 |

해당 그래프에서 cost의 최저점인 곳을 찾는 것이 목표입니다.

0이므로 W는 1이 최저점이고 목표로 한 값입니다.

GD(Gradient Descent) : 경사 감소 알고리즘으로써 최소 값을 찾는데 많이 이용되는 알고리즘입니다. 해당 알고리즘은 경사의 감소를 따라서 최소 지점을 구할 수 있게 해줍니다. 미분을 이용하여 경사도를 구하며 어느지점에서 사용이 가능하고 W값의 변화에 따라 cost가 줄어드며 해당 과정을 반복하여 최종 목표인 최저점을 찾게 됩니다.

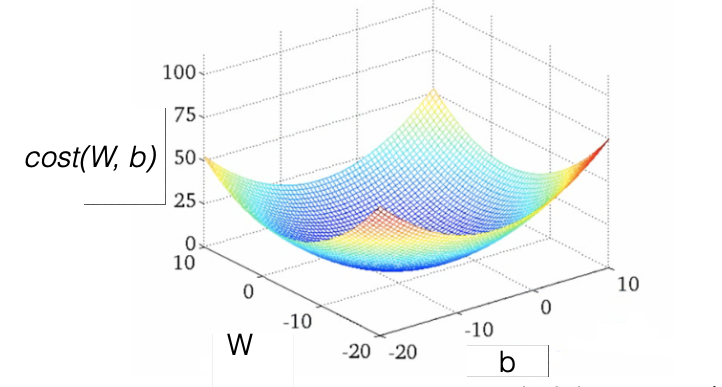

cost의 그래프 모양은 이런 모양이 되는지 확인해야하며 이러한 모양을 convex function이라고합니다.

어느지점에서 시작하든지 최저점으로 도달하는것입니다.

'학습(구) > AI' 카테고리의 다른 글

| Multivariable linear regression (0) | 2020.09.10 |

|---|---|

| Linear Regression minimize cost 실습 (0) | 2020.09.07 |

| Linear Regression 실습 (0) | 2020.09.06 |

| Linear Regression (0) | 2020.09.06 |

| TensorFlow의 기본/jupyter notebook 설치 (0) | 2020.09.06 |